分布式系统核心 数据处理与存储服务的架构要点

在当今大数据与高并发时代,分布式框架已成为构建可扩展、高可用应用系统的基石。其核心在于如何高效、可靠地处理与存储海量数据。本文将深入探讨分布式框架中数据处理与存储服务的关键要点。

一、 数据处理要点

- 数据分区与分片:将大规模数据集水平分割成更小的、可管理的单元(分片),并分布到不同的计算节点上。这是实现并行处理与横向扩展的基础。策略上需考虑键值范围、哈希一致性等,以平衡负载并避免热点。

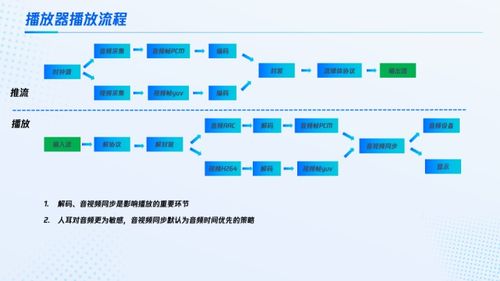

- 并行计算模型:采用如MapReduce、Flink流处理或Spark内存计算等模型,将计算任务分解为可在多个节点上并行执行的子任务。关键在于设计无状态或状态可管理的任务,并高效处理任务间的数据交换(Shuffle)。

- 容错与状态管理:分布式环境下,节点故障是常态。系统需通过检查点(Checkpointing)、状态复制或 lineage(血缘关系)重建等机制,确保计算状态的持久化与故障后的快速恢复,保证 Exactly-Once 或 At-Least-Once 的语义。

- 数据流水线与流批一体:现代架构趋向于统一流(实时)处理和批(历史)处理。要点在于设计低延迟的数据流水线,支持事件时间处理、窗口操作,并能无缝融合实时流与批量数据源。

- 资源管理与调度:由YARN、Kubernetes或Mesos等协调器负责集群资源的统一管理与任务调度,实现资源的弹性分配与隔离,最大化集群利用率。

二、 数据存储服务要点

- 存储模型多样性:根据数据特性和访问模式,选择合适的存储模型:

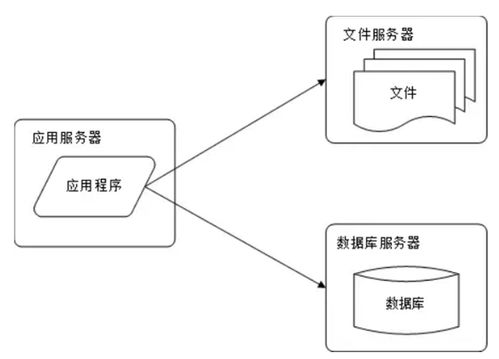

- 分布式文件系统(如HDFS、S3):用于存储海量非结构化或半结构化数据,提供高吞吐量的顺序访问。

- NoSQL数据库(如Cassandra、HBase):为键值、宽列、文档或图数据提供高可用的低延迟随机访问,通常牺牲强一致性换取可用性与分区容错性(遵循CAP定理)。

- 分布式SQL/NewSQL数据库(如CockroachDB、TiDB):在分布式环境下提供类似传统关系数据库的ACID事务与SQL接口,挑战在于分布式事务与一致性协议(如Raft、Paxos)的实现。

- 数据复制与一致性:数据通常跨多个节点或数据中心复制以保证可用性和耐久性。这引出了核心的一致性模型选择:

- 强一致性:所有副本同步更新,读写立即可见,但可能影响可用性与延迟。

- 最终一致性:允许副本间短暂不一致,但最终达到一致,提供更高的可用性。

需要根据业务容忍度权衡选择,并辅以版本向量、冲突解决等机制。

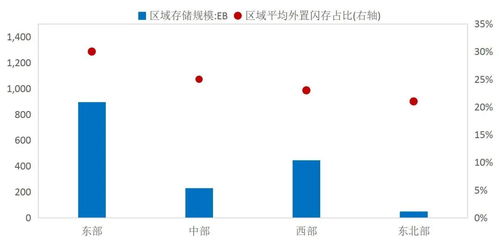

- 分区与负载均衡:存储服务同样依赖数据分区来分散负载。一致性哈希是常用技术,它能最小化节点变动时的数据迁移。需要监控热点分区并进行动态调整。

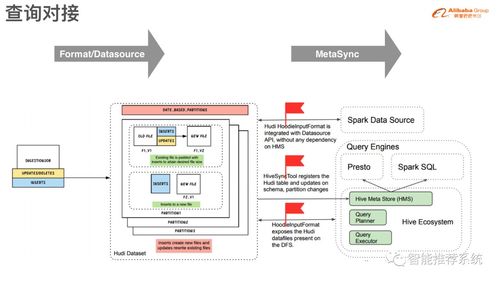

- 索引与查询优化:在分布式存储上建立高效的二级索引是一大挑战。全局索引可能成为瓶颈,而本地索引则查询复杂。需设计如倒排索引、布隆过滤器等结构,并优化分布式查询计划,减少跨网络数据移动。

- 持久化与存储引擎:底层存储引擎(如LSM-Tree、B-Tree变种)的选择深刻影响读写性能。要点在于优化磁盘I/O、利用内存缓存(如BlockCache、MemTable),并平衡写放大、读放大与空间放大问题。

三、 数据处理与存储的协同

- 数据本地性:调度计算任务时,应尽量使其在存储有所需数据副本的节点上执行(“移动计算而非数据”),大幅减少网络传输开销。

- 统一的服务发现与配置管理:使用ZooKeeper、etcd或Consul等服务,协调数据处理组件与存储服务的发现、元数据管理与配置一致性。

- 可观测性与运维:建立完善的监控(如Metrics)、日志集中收集与链路追踪体系,对数据处理流水线的吞吐量、延迟以及存储服务的健康度、容量进行实时洞察,是实现稳定运维的保障。

一个健壮的分布式框架,其数据处理与存储服务的设计必须紧密围绕可扩展性、容错性、一致性与性能这四大支柱进行权衡与创新。随着云原生与Serverless范式的发展,存算分离、弹性伸缩和自动化运维正成为新的演进方向,但上述核心要点依然是架构师设计与评估系统时的根本依据。

如若转载,请注明出处:http://www.xinyuan-technology.com/product/41.html

更新时间:2026-02-28 09:18:24